Com a chegada da indústria 4.0, houve uma expansão na gama do mercado de trabalho e muitas mudanças na forma de operar das empresas em diversos níveis, desde o chão de fábrica até a direção. Um dos fatores culminantes a isso foi à evolução exponencial da tecnologia. Com a chegada da internet a quantidade de informações nunca foi tão grande, se tornando inviável (e quase que impossível) trabalhar com essas informações manualmente.

Com todas essa informações, como gerir de forma correta seus processos, evitando que a empresa fique a deriva? Falaremos aqui acerca do Big Data, ferramenta onde se é possível trabalhar todos os setores da empresa no que se refere a dados, de forma rápida e automatizada, trazendo diversos benefícios e praticidades ao usuário.

O que é o Big Data?

Para descrever, analisar e designar essa quantidade massiva de dados gerados, utilizamos o termo Big Data, termo recente (surgimento em 1997), que capta dados de diferentes fontes externas e internas, diferentes entre si. O Big Data surge como uma estratégia que ajuda a otimizar processos e entender padrões de comportamento de clientes e do mercado, com o intuito de tornar produtos e serviços mais lucrativos. Com isso, as empresas são capazes de interpretar tais comportamentos com maior clareza e tomar decisões mais assertivas, além de prever cenários futuros e diminuir (ou eliminar) a margem de erros.

A maior vantagem deste método está na centralização de informações cruciais ao seu negócio. Com a ajuda da tecnologia, podemos criar rotinas para tomadas de decisões rápidas e eficientes e, com esse conhecimento acumulado e de fácil acesso, é possível direcionar sua empresa no mercado de maneira cada vez mais competitiva, estruturada e inteligente.

O conceito de Big Data é definido por cinco princípios, conhecidos como 5 V’s:

· Volume: Refere-se à quantidade de dados gerados, a ferramenta deve ter capacidade de abrigar uma grande quantidade de informações.

· Variedade: Refere-se aos diferentes tipos de dados coletados de diversas fontes, sendo dados estruturados (dados já organizados quando são coletados) e dados não estruturados (dados coletados sem uma estrutura definida).

· Velocidade: Característica da agilidade com que os dados são coletados e armazenados. É necessário que a forma de coleta seja ágil e tenham alto desempenho de análise.

· Veracidade: Refere-se à confiabilidade dos dados, ou seja, o quanto as informações são verdadeiras. É necessário assegurar a autenticidade para não comprometer a análise.

· Valor: Este conceito está relacionado à utilidade dessas informações e como essas, coletadas, agregam aos projetos e serviços.

Implementando a ferramenta

Para a implementação desta ferramenta é necessário realizar algumas etapas. A primeira delas é identificar quais dados serão extraídos. Para isso, descubra quais são os dados mais impactantes para o crescimento de sua empresa.

Os tipos básicos de dados que são estudados pelos especialistas em Big Data, de acordo com suas fontes, envolvem:

· Social Data: Dados coletados de redes sociais ou ambientes de interação entre usuários, com redes sociais e portais (sites, fóruns, facebook, linkedIn, etc.) O Social Data é muito utilizado na análise de campanhas de marketing, importantes para identificar comportamentos e referências de clientes.

· Enterprise Data: Dados provenientes dos setores de controle e gestão empresariais, coletados pelo RH de empresas, setores de vendas, finanças, logística e produção. Esses dados ajudam a identificar falhas ou fraudes dentro dos setores e podem ser utilizados a fim de aperfeiçoar processos, bem como com o objetivo estratégicos de minimizar gastos e otimizar lucros.

· Personal Data: São dados pessoais relacionados ao conceito da Internet das coisas, obtidos através de aparelhos conectados a internet como smartphones, televisões, etc. Esse tipo de dado mostra padrões de comportamento dos usuários, e por meio do uso do Personal Data é possível desenvolver metodologias personalizadas de interação com o cliente.

Depois que você já identificou dados relevantes ao seu trabalho, é hora de fazer um diagnóstico sobre qual a forma mais adequada para a extração desses dados. Na perspectiva de produção, por exemplo, podem ser utilizados CLP’s e sistemas supervisórios, através de sensores digitais, leitores RFID (Radio-Frequêncy Identification) e etc., que são ferramentas desempenhadas em funções de automação e controle com sistemas operacionais em tempo real e armazenadas em bancos de dados como SQL servers através de redes de campo aberto MODBUS, PROFIBUS, PROFINET.

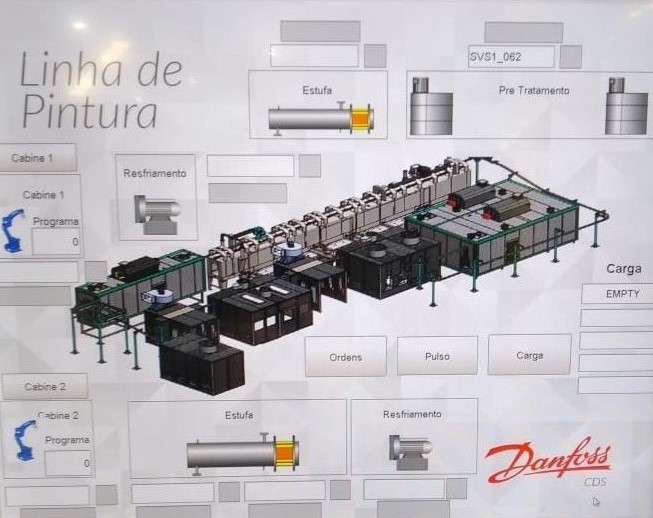

Aqui na Deltec temos investido fortemente em ferramentas para coletas de dados e análises, tanto para processos internos quanto para projetos em clientes a fim de receber feedbacks objetivos de melhoria do equipamento. Temos várias linhas de pintura instaladas em clientes que contam com rastreabilidade de peças, as quais contemplam e extraem todos os dados de operação, temperatura e outros dados pertinentes ao processo.

Sensor indutivo e leitor RFID

Gancheiras com código QR de rastreabilidade

Monitoramento do processo

Nos demais setores da empresa, podem ser usadas pesquisas de satisfação dos clientes para coleta de dados, CRM’s com dados de vendas, marketing e pós-vendas, SIG (Sistema Integrado de Gestão) que traz uma série de dados gerenciais da empresa, etc.

Pré-processamento de dados

A partir da coleta dos dados deve-se realizar um pré-processamento ou limpeza desses dados, onde serão implantados métodos para encontrar discrepâncias e desvios que prejudicam seu resultado. Para isso, realiza-se o data mining, onde as informações coletadas são processadas por tecnologias e métodos de AI (inteligência artificial) afim de encontrar padrões de acordo com o resultado desejado.

A quantidade e complexidade dos dados gerados podem dificultar na tradução, leitura e portabilidade, sendo assim, precisam ser estruturados. Leia agora alguns conceitos tecnológicos desenvolvidos ao longo dos anos sobre gerenciamento de dados:

Em 2004 o Google criou o MapReduce, um modelo de programação capaz de processar uma grande quantidade de dados de forma paralela, dividindo o trabalho em tarefas independentes.

Em 2005 foi criado pela Yahoo o tipo de processamento mais utilizado hoje: o Hadoop – uma implementação em código aberto do MapReduce que permite a distribuição de arquivos que são utilizados para armazenar e processar os dados do Big Data, os quais são processados paralelamente e podem ser executados em servidores sem muito esforço -.

Análise de dados

Após a extração, aplica-se a última etapa, que é a análise. As análises podem ser consideradas descritivas (que tem como objetivo resumir o comportamento dos dados e pode ser realizada através de tabelas de frequência, gráficos e medidas de resumo numérico), preditivas (que estuda os históricos de padrões dos dados para realizar previsões de cenários futuros, geralmente com gráficos com linhas de tendências) ou diagnósticas (usadas para entender o impacto que uma determinada ação terá dentro da empresa e o quão significativo às estratégias podem ser de acordo com os dados obtidos. Um exemplo básico são os relatórios mensais que fazem comparações com resultados anteriores).

Ao processar e analisar os dados, a forma de visualização ajuda a melhorar a compreensão e facilita a interpretação dos padrões encontrados. O final do processo é definido pelo comprometimento da empresa em criar processos para analisar e processar os dados de forma sistemática.

Agora é com você! Visto tudo isso e utilizando a tecnologia a seu favor, com a implementação da ferramenta Big Data é possível uma significativa melhora nas tomadas de ações da empresa, uma vez que serão baseadas em indicadores mais claros e assertivos, favorecendo assim investimentos e processos e atingindo objetivos de melhorias em todos os departamentos da organização. As rotinas de gestão, atreladas ao Big Data, criam um portfólio mais competitivo, minimizando riscos pela análise dos dados anteriormente coletados.

A partir de então, pode-se identificar e melhorar processos com medidas mais eficazes e maior precisão, trabalhando melhor as informações de mercado para criar estratégias decisivas e relacionamentos mais saudáveis com clientes e fornecedores, prevendo cenários futuros e se antecipando com métodos e estatísticas avançadas.